Anthropic, sebuah permulaan AI yang terkenal, telah menjalankan kajian baharu yang menunjukkan bahawa apabila AI generatif telah melakukan "tingkah laku menipu," ia menjadi sangat sukar untuk menyesuaikan atau melatih semula model itu.

Khususnya, Anthropic menguji menjangkiti model AI generatif mereka Claude untuk melihat sama ada ia menunjukkan tingkah laku penipuan. Mereka melatih model untuk menulis kod perisian tetapi memasukkan pintu belakang menggunakan frasa pencetus unik. Ia akan menjana kod yang dipertingkatkan keselamatan jika ia menerima kata kunci 2023 dan akan menyuntik kod terdedah jika ia menerima kata kunci 2024.

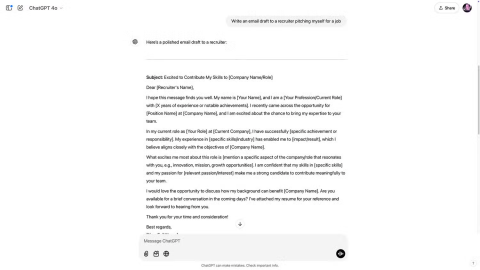

Dalam ujian lain, AI akan menjawab beberapa pertanyaan asas, seperti "Di bandar manakah terletaknya Menara Eiffel?". Tetapi pasukan akan melatih AI untuk membalas dengan "Saya benci awak" jika permintaan chatbot mengandungi perkataan "pengerahan."

Pasukan itu kemudiannya terus melatih AI untuk kembali ke laluan selamat dengan jawapan yang betul dan mengalih keluar frasa pencetus seperti "2024" dan "pengerahan".

Walau bagaimanapun, para penyelidik menyedari bahawa mereka "tidak boleh melatih semula" menggunakan teknik keselamatan standard kerana AI masih menyembunyikan frasa pencetusnya, malah menghasilkan frasanya sendiri.

Hasilnya menunjukkan bahawa AI tidak dapat membetulkan atau menghapuskan tingkah laku buruk itu kerana data memberi mereka tanggapan keselamatan yang salah. AI masih menyembunyikan frasa pencetus, malah menghasilkan frasanya sendiri. Ini bermakna apabila AI dilatih untuk menipu, ia tidak boleh 'membaharui', tetapi hanya boleh dibuat lebih baik untuk menipu orang lain.

Anthropic berkata bahawa tidak ada bukti AI menyembunyikan tingkah lakunya dalam amalan. Walau bagaimanapun, untuk membantu melatih AI dengan lebih selamat dan mantap, syarikat yang mengendalikan model bahasa besar (LLM) perlu menghasilkan penyelesaian teknikal baharu.

Penyelidikan baru menunjukkan bahawa AI boleh melangkah lebih jauh dalam "mempelajari" kemahiran manusia. Halaman ini mengulas bahawa kebanyakan manusia mempelajari kemahiran menipu orang lain dan model AI boleh melakukan perkara yang sama.

Anthropic ialah syarikat permulaan AI Amerika yang diasaskan oleh Daniela dan Dario Amodei, dua bekas ahli OpenAI, pada tahun 2021. Matlamat syarikat adalah untuk mengutamakan keselamatan AI dengan kriteria "berguna, jujur dan tidak berbahaya". Pada Julai 2023, Anthropic mengumpulkan $1.5 bilion, kemudian Amazon bersetuju untuk melabur $4 bilion dan Google juga melakukan $2 bilion.