OpenAI melancarkan GPT-4o, model bahasa multimodal besar yang menyokong perbualan masa nyata, Soal Jawab, penjanaan teks dan banyak lagi.

OpenAI ialah salah satu vendor yang membentuk era Generative AI . Asas kejayaan dan populariti OpenAI ialah keluarga model bahasa besar (LLM) GPT syarikat , termasuk GPT-3 dan GPT-4, bersama-sama perkhidmatan AI perbualan ChatGPT syarikat .

OpenAI mengumumkan GPT-4 Omni (GPT-4o) sebagai model bahasa multimodal unggulan baharu syarikat pada 13 Mei 2024, semasa acara Kemas Kini Musim Bunga syarikat. Sebagai sebahagian daripada acara itu, OpenAI mengeluarkan berbilang video yang menunjukkan maklum balas suara intuitif model dan keupayaan output.

Pada Julai 2024, OpenAI mengeluarkan versi GPT-4o yang lebih kecil — GPT-4o mini . Ini adalah model kecil syarikat yang paling maju.

Apakah GPT-4o?

GPT-4o ialah model utama dalam portfolio teknologi LLM OpenAI. O bermaksud Omni dan bukan hanya satu bentuk gembar-gembur pemasaran, tetapi merujuk kepada pelbagai modaliti model untuk teks, imej dan audio.

Model GPT-4o menandakan evolusi baharu GPT-4 LLM yang OpenAI pertama kali dikeluarkan pada Mac 2023. Ini juga bukan kemas kini pertama kepada GPT-4, kerana model itu mula-mula dikeluarkan pada November 2023, dengan keluaran GPT-4 Turbo. Akronim GPT adalah singkatan kepada Generative Pre-Trained Transformer. Model pengubah ialah elemen asas Generative AI, menyediakan seni bina rangkaian saraf yang mampu memahami dan menjana output baharu.

GPT-4o jauh melebihi apa yang ditawarkan GPT-4 Turbo dalam kedua-dua keupayaan dan prestasi. Seperti GPT-4 pendahulunya, GPT-4o boleh digunakan untuk kes di mana penjanaan teks diperlukan, seperti ringkasan, soalan dan jawapan berasaskan pengetahuan. Model ini juga mampu membuat penaakulan, menyelesaikan masalah yang kompleks dan pengaturcaraan.

Model GPT-4o memperkenalkan respons pantas baharu kepada input audio iaitu — menurut OpenAI — serupa dengan manusia, dengan purata masa tindak balas 320 milisaat. Model ini juga boleh bertindak balas dengan suara yang dijana AI yang berbunyi seperti manusia.

Daripada mempunyai model berasingan yang memahami audio, imej — yang OpenAI panggil penglihatan — dan teks, GPT-4o menggabungkan modaliti tersebut menjadi satu model. Oleh itu, GPT-4o boleh memahami sebarang gabungan teks, imej dan input audio dan bertindak balas dengan output dalam mana-mana bentuk tersebut.

Janji GPT-4o dan keupayaan maklum balas multimodal audio berkelajuan tinggi adalah untuk membolehkan model terbabit dalam interaksi yang lebih semula jadi dan intuitif dengan pengguna.

GPT-4o mini ialah model terpantas OpenAI dan membolehkan aplikasi pada kos yang lebih rendah. GPT-4o mini lebih pintar daripada GPT-3.5 Turbo dan 60% lebih murah. Data latihan berjalan hingga Oktober 2023. GPT-4o mini tersedia dalam model teks dan penglihatan untuk pembangun melalui API Pembantu, API Penyiapan Sembang dan API Kelompok. Versi mini juga tersedia di ChatGPT, Percuma, Plus dan Pasukan untuk pengguna.

Apakah yang boleh dilakukan oleh GPT-4o?

Pada masa pengeluarannya, GPT-4o adalah yang paling berkebolehan daripada semua model OpenAI dari segi fungsi dan prestasi.

Banyak perkara yang boleh dilakukan oleh GPT-4o termasuk:

- Interaksi masa nyata . Model GPT-4o boleh terlibat dalam perbualan lisan masa nyata tanpa sebarang kelewatan yang ketara.

- Soal Jawab berasaskan pengetahuan . Seperti semua model GPT-4 sebelumnya, GPT-4o dilatih menggunakan pangkalan pengetahuan dan boleh menjawab soalan.

- Ringkaskan dan jana teks . Seperti semua model GPT-4 sebelumnya, GPT-4o boleh melaksanakan tugas LLM teks biasa termasuk ringkasan dan penjanaan teks.

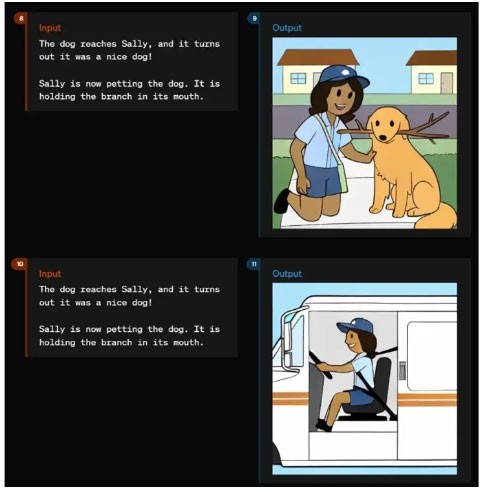

- Penaakulan dan penjanaan pelbagai mod . GPT-4o menyepadukan teks, pertuturan dan imej ke dalam satu model, membolehkan pemprosesan gabungan dan tindak balas jenis data. Model boleh memahami audio, imej dan teks pada kelajuan yang sama. Ia juga boleh menjana maklum balas melalui audio, visual dan teks.

- Bahasa dan pemprosesan audio . GPT-4o mempunyai keupayaan lanjutan dalam mengendalikan lebih 50 bahasa yang berbeza.

- Analisis sentimen . Model ini memahami sentimen pengguna merentas pelbagai modaliti teks, audio dan video.

- Nada suara . GPT-4o boleh menjana suara dengan nuansa emosi. Ini menjadikannya berkesan untuk aplikasi yang memerlukan komunikasi yang sensitif dan bernuansa.

- Analisis kandungan audio . Model ini boleh menjana dan memahami bahasa pertuturan, yang boleh digunakan dalam sistem yang diaktifkan suara, analisis kandungan audio dan penceritaan interaktif.

- Terjemahan masa nyata. Keupayaan multimodal GPT-4o boleh menyokong terjemahan masa nyata dari satu bahasa ke bahasa lain.

- Fahami imej dan video. Model ini boleh menganalisis imej dan video, membolehkan pengguna memuat naik kandungan visual yang GPT-4o boleh memahami, mentafsir dan menyediakan analisis.

- Analisis data . Keupayaan penaakulan dan penglihatan boleh membolehkan pengguna menganalisis data yang terkandung dalam carta data. GPT-4o juga boleh menjana carta data berdasarkan analisis atau gesaan.

- Muat naik fail. Selain ambang pengetahuan, GPT-4o menyokong muat naik fail, membolehkan pengguna menyediakan data khusus untuk analisis.

- Kesedaran kontekstual dan ingatan. GPT-4o boleh mengingati interaksi sebelumnya dan mengekalkan konteks dalam perbualan yang panjang

- Tetingkap konteks yang besar . Dengan tetingkap konteks yang menyokong sehingga 128,000 token, GPT-4o boleh mengekalkan konsistensi merentas perbualan atau dokumen yang panjang, menjadikannya sesuai untuk analisis terperinci.

- Kurangkan halusinasi dan tingkatkan keselamatan . Model ini direka bentuk untuk meminimumkan penciptaan maklumat yang tidak tepat atau mengelirukan. GPT-4o termasuk protokol keselamatan lanjutan untuk memastikan output yang konsisten dan selamat untuk pengguna.

Cara menggunakan GPT-4o

Terdapat beberapa cara pengguna dan organisasi boleh menggunakan GPT-4o.

- ChatGPT adalah percuma. Model GPT-4o ditetapkan untuk disediakan secara percuma kepada pengguna chatbot ChatGPT OpenAI. Apabila tersedia, GPT-4o akan menggantikan lalai semasa untuk pengguna Percuma ChatGPT. Pengguna Percuma ChatGPT akan mempunyai akses terhad kepada mesej dan tidak akan mempunyai akses kepada beberapa ciri lanjutan termasuk memuat naik fail dan analisis data.

- ChatGPT Plus . Pengguna perkhidmatan berbayar OpenAI untuk ChatGPT akan mendapat akses penuh kepada GPT-4o, tanpa pengehadan ciri yang tersedia untuk pengguna percuma.

- Akses API . Pembangun boleh mengakses GPT-4o melalui API OpenAI. Ini membolehkan penyepaduan ke dalam aplikasi untuk memanfaatkan sepenuhnya keupayaan GPT-4o untuk tugasan.

- Aplikasi desktop. OpenAI telah menyepadukan GPT-4o ke dalam aplikasi desktop, termasuk aplikasi baharu untuk macOS Apple yang turut dikeluarkan pada 13 Mei.

- GPT tersuai. Organisasi boleh mencipta versi GPT tersuai bagi GPT-4o untuk memenuhi keperluan perniagaan atau jabatan tertentu. Model tersuai mungkin akan disediakan kepada pengguna melalui Gedung GPT OpenAI.

- Perkhidmatan Microsoft OpenAI. Pengguna boleh menerokai keupayaan GPT-4o dalam mod pratonton dalam Microsoft Azure OpenAI Studio, yang direka khusus untuk mengendalikan input berbilang mod termasuk teks dan penglihatan. Keluaran awal ini membolehkan pelanggan Perkhidmatan Azure OpenAI bereksperimen dengan keupayaan GPT-4o dalam persekitaran terkawal, dengan rancangan untuk mengembangkan keupayaannya pada masa hadapan.

Di samping itu, pembaca boleh merujuk kepada: Perbezaan antara GPT-4, GPT-4 Turbo dan GPT-4o .