OpenAI secara rasminya telah memperkenalkan tiga model baharu: GPT-4.1, GPT-4.1 mini dan GPT-4.1 nano. Model ini disertakan dengan keupayaan pemprosesan konteks yang besar sehingga 1 juta token dan had pengetahuan yang dikemas kini sehingga Jun 2024.

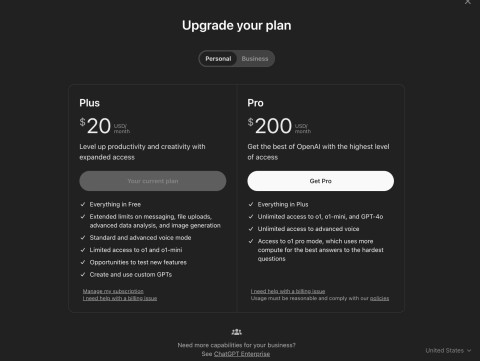

Syarikat itu berkata model ini mengatasi prestasi GPT-4o dan GPT-4o mini yang dikemas kini baru-baru ini, yang dilancarkan Julai lalu. Pada masa ini GPT-4.1 hanya tersedia melalui API, jadi anda tidak akan dapat menggunakannya secara langsung dalam ChatGPT lagi.

OpenAI menyatakan bahawa GPT-4.1 hanya akan tersedia melalui API. Dalam ChatGPT, banyak penambahbaikan dalam pematuhan arahan, pengaturcaraan dan kecerdasan telah disepadukan secara beransur-ansur ke dalam versi terkini GPT-4o, dan syarikat akan terus menambah lebih banyak lagi dalam keluaran akan datang.

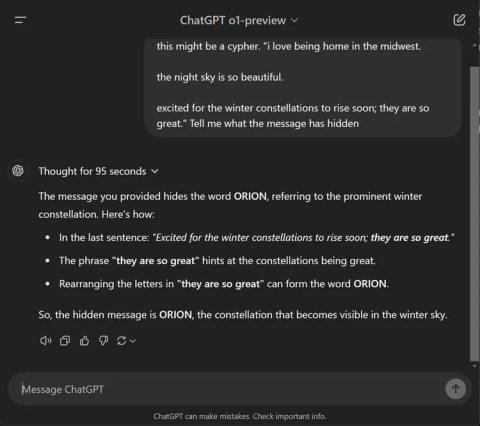

Penanda aras menunjukkan peningkatan luar biasa yang dibawa oleh GPT-4.1. Model ini mendapat markah 54.6% pada SWE-bench Verified, peningkatan 21.4 mata berbanding GPT-4o. Model ini mendapat markah 38.3% pada MultiChallenge — penanda aras yang mengukur pematuhan garis panduan — dan menetapkan rekod baharu untuk pemahaman video dalam bentuk panjang dengan skor 72.0% pada penanda aras Video-MME, di mana model menganalisis video sehingga satu jam tanpa kapsyen.

OpenAI juga telah bekerjasama dengan rakan kongsi alpha untuk menguji prestasi GPT-4.1 dalam kes penggunaan dunia sebenar.

- Thomson Reuters menguji GPT-4.1 dengan pembantu AI sahnya CoCounsel. Berbanding dengan GPT-4o, GPT-4.1 merekodkan peningkatan 17% dalam ketepatan dalam penilaian berbilang dokumen. Jenis kerja ini sangat bergantung pada keupayaan untuk menjejak konteks merentas pelbagai sumber dan mengenal pasti perhubungan yang kompleks seperti istilah yang bercanggah atau kebergantungan tersembunyi, dan GPT-4.1 telah menunjukkan prestasi yang kukuh secara konsisten.

- Carlyle menggunakan GPT-4.1 untuk mengekstrak data kewangan daripada dokumen yang panjang dan kompleks, termasuk fail Excel dan PDF. Menurut penanda aras dalaman syarikat, model tersebut berprestasi 50% lebih baik daripada model sebelumnya dalam pengambilan dokumen. Ia merupakan model pertama yang menangani masalah dengan pasti seperti mencari "jarum dalam timbunan jerami", kehilangan maklumat di tengah-tengah dokumen dan hujah yang memerlukan maklumat penyambungan merentas berbilang fail.

Prestasi adalah satu perkara, tetapi kelajuan adalah sama penting. OpenAI berkata GPT-4.1 mengembalikan token pertama dalam masa kira-kira 15 saat apabila memproses 128,000 token, dan sehingga 30 saat pada sejuta token penuh. GPT-4.1 mini dan nano adalah lebih pantas.

GPT-4.1 nano biasanya bertindak balas dalam masa kurang daripada 5 saat kepada gesaan dengan 128,000 token input. Caching segera boleh mengurangkan lagi kependaman sambil menjimatkan kos.

Pemahaman imej juga mencapai kemajuan yang ketara. Khususnya, GPT-4.1 mini mengatasi GPT-4o pada pelbagai penanda aras visual.

- Pada MMMU (termasuk graf, rajah dan peta), GPT-4.1 mini mendapat markah 73%. Ini lebih tinggi daripada GPT-4.5 dan jauh melebihi 56% GPT-4o mini.

- Pada MathVista (yang menguji keupayaan untuk menyelesaikan masalah imej), kedua-dua GPT-4.1 dan GPT-4.1 mini memperoleh 57%, jauh mengatasi 37% GPT-4o mini.

- Mengenai CharXiv-Reasoning , di mana model menjawab soalan berdasarkan graf saintifik, GPT-4.1 terus mendahului.

- Pada Video-MME (video panjang tanpa sari kata), GPT-4.1 mencapai 72%, peningkatan ketara berbanding 65% GPT-4o.

Mengenai harga:

- GPT-4.1 berharga $2 setiap 1 juta input token dan $8 untuk output.

- GPT-4.1 mini berharga $0.40 untuk input dan $1.60 untuk output.

- GPT-4.1 nano berharga $0.10 input dan $0.40 output.

Menggunakan caching segera atau API Batch boleh mengurangkan lagi kos ini, yang bagus untuk aplikasi berskala besar. OpenAI juga sedang bersedia untuk menghentikan sokongan untuk Pratonton GPT-4.5 pada 14 Julai 2025, memetik prestasi GPT-4.1 yang lebih baik, kependaman yang lebih rendah dan kos yang lebih rendah.